YOLO或者其他模型怎么集成到dify中?这是一个非常棒和具体的应用场景!您这个“施工安全智能监测”的想法非常适合用YOLO和SAM的组合来实现。这是一个经典的目标检测+实例分割 pipeline,技术上非常成熟可行。

我来为您梳理一个清晰的实现方案和技术选型建议。

整体技术思路

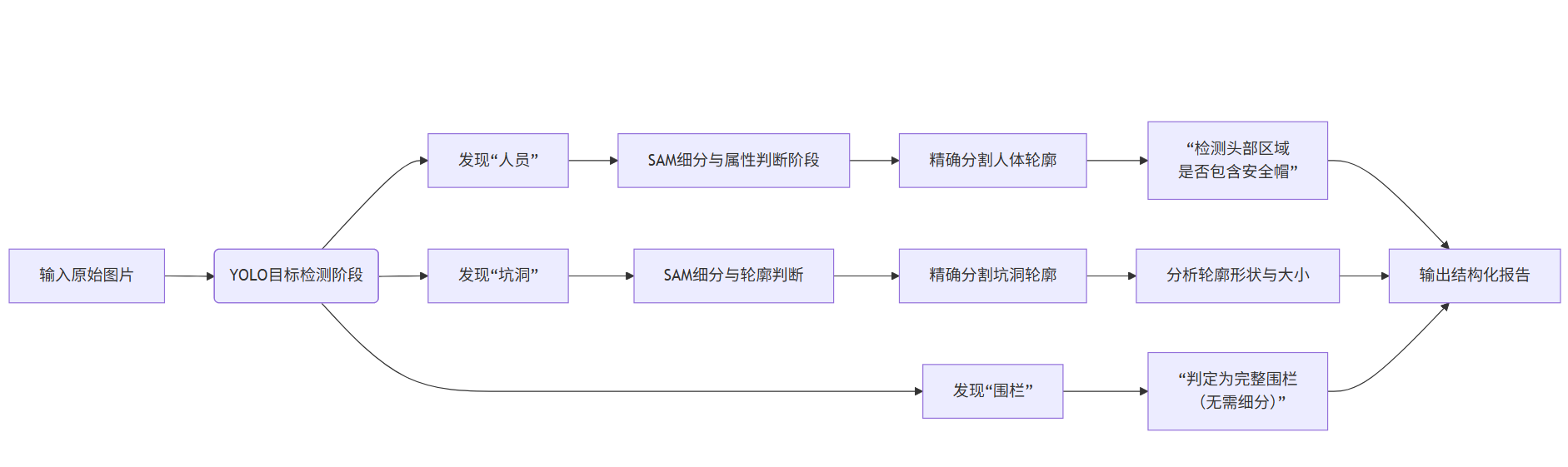

您的需求可以拆解为两个主要阶段,其工作流程可以参考下图:

下面我们详细拆解每个阶段。

阶段一:YOLO 目标检测(发现问题目标)

这是第一步,用YOLO模型在图片中快速定位出您关心的几类目标:

人员(Person)

安全帽(Helmet)/(也可以直接检测“人员”是否戴安全帽)

坑洞(Pit)

围栏/警戒线(Fence/Barrier)

技术选型建议:

YOLOv8:Ultralytics 公司维护,API 非常友好,训练简单,生态成熟。是当前最推荐入门和部署的版本。

YOLOv9:最新版本,在精度和效率上有进一步提升。但新出炉可能社区和资源相对少一些。

YOLOv5:虽然较旧,但极其稳定,资料丰富,完全够用。

您的任务: 您需要收集大量施工现场的图片,并标注上述几类目标框,然后用自己的数据对预训练的YOLO模型进行微调,这样它才能特别擅长识别您关心的这些场景。

阶段二:SAM 图像分割(精细分析目标)

在YOLO定位到目标后,使用SAM对特定目标进行像素级的精细分割:

对于“人员”:将YOLO检测到的“人员”框作为提示输入给SAM,SAM会输出该人员的精确像素掩膜。基于这个精确的人体轮廓,可以进一步分析头部区域,从而更准确地判断是否佩戴安全帽。

对于“坑洞”:同样将YOLO检测到的“坑洞”框提示给SAM,得到坑洞的精确形状和大小。这可以用于判断坑洞的规模、是否规则等。

对于“围栏”:可能不需要SAM,YOLO检测到“围栏”本身就可以作为一個安全指标。但如果需要判断围栏是否连续、完整,SAM也能发挥作用。

技术选型建议:

SAM(Segment Anything Model):Meta 的原版模型,精度高。有

vit_h,vit_l,vit_b三种规模的模型,越大越精确,也越慢。MobileSAM 或 FastSAM:SAM的加速版或轻量版,速度更快,更适合实时或对速度要求高的场景,精度略有牺牲。

平台与工具推荐(针对您的需求)

基于您要“自己训练”和“在Dify中调用”的需求,下表是更具体的推荐:

| 任务 | 推荐工具/平台 | 理由 |

|---|---|---|

| YOLO模型训练 | Ultralytics HQ(YOLOv8/v9) | 提供完美的Python库(ultralytics),几行代码就能开始训练。有丰富的文档和社区支持。这是目前最主流和简单的选择。 |

| SAM模型使用 | Meta SAM(GitHub) | 官方实现,直接使用其GitHub仓库或PyPI安装(segment-anything包)。提供预训练模型,开箱即用。 |

| 数据标注 | LabelImg(标检测框), LabelMe/CVAT(标分割掩膜) | 您需要标注工具来准备训练YOLo的数据。LabelImg 用于标注边界框简单快捷。如果需要为SAM准备精细标注,可以用LabelMe或CVAT。 |

| 最终集成到 Dify | 将YOLO+SAM Pipeline部署为API | 这是关键一步。您需要将训练好的YOLO模型和SAM模型整合成一个服务(例如用FastAPI编写),该服务接收图片,返回结构化的JSON结果(如:{“有无坑洞": true, "有无围栏": false, "人员是否戴安全帽": [true, false]})。然后在Dify中将其设置为自定义工具进行调用。 |

具体实施步骤参考

环境准备:安装Python、PyTorch、

ultralytics包(用于YOLO)、segment-anything包(用于SAM)。数据收集与标注:

收集大量包含坑洞、围栏、戴/不戴安全帽人员的施工现场图片。

使用 LabelImg 工具,为每张图片标注出上述目标的边界框,并打上标签。

训练YOLO模型:

使用

ultralytics库,加载预训练权重(如yolov8n.pt)。在自己的标注数据上进行微调。这个过程大部分是自动化的。

搭建推理Pipeline:

编写一个Python脚本:

a. 第一步:用训练好的YOLO模型推理图片,得到边界框和类别。

b. 第二步:对于YOLo识别出的“人员”和“坑洞”框,将其作为提示输入SAM模型,得到精确的分割掩膜。

c. 第三步:基于分割结果进行逻辑判断(如:在人员的掩膜上,分析头部区域的颜色或纹理特征来判断安全帽)。部署为API并接入Dify:

将上述Pipeline用 FastAPI 或 Flask 封装成一个HTTP服务器。它提供一个接口,比如

/analyze,接收图片,返回JSON结果。在Dify的“工具”设置中,添加一个自定义工具,填写您的API地址和参数。

注意事项

数据质量是关键:模型的性能极度依赖于您标注的数据。数据要尽可能覆盖各种天气、光照、角度的施工现场场景。

性能考量:YOLO+SAM的pipeline在计算上有一定开销。如果追求实时性,需要考虑使用轻量级模型(如YOLOv8s, MobileSAM)和GPU加速。

安全帽判断逻辑:这是一个小课题。除了用分割轮廓分析,也可以训练一个专门的二分类模型(戴/不戴安全帽)来更精确地判断头部区域。

这个方案非常扎实,是计算机视觉技术的典型工业应用。如果您能搞定数据标注,后续的训练和集成工作是有清晰的路径可循的。

希望这个详细的方案能帮助您顺利启动项目!如果您在具体步骤(比如YOLO训练或API编写)上遇到问题,我们可以再深入探讨。